Deep fake: яке ж сутнісне дно глибокого фейку?

Христина Фроляк

Опубліковано: 08-11-2019

Розділи: За що критикують медіа?, Фальсифікація, містифікація.

0

Інформаційний хаос в сьогоденні зумовлений громіздкою кількістю фейків, які створюють значну конкуренцію достовірним публікаціям і вводять в оману безліч інтернет-користувачів. Щороку фото- та відеопідробки стають дедалі переконливішими. Нині набирає обертів явище «deep fakе», яке журналісти Радіо Свободи вже найменували «наступним поколінням фейкових новин».

Що ж воно таке?

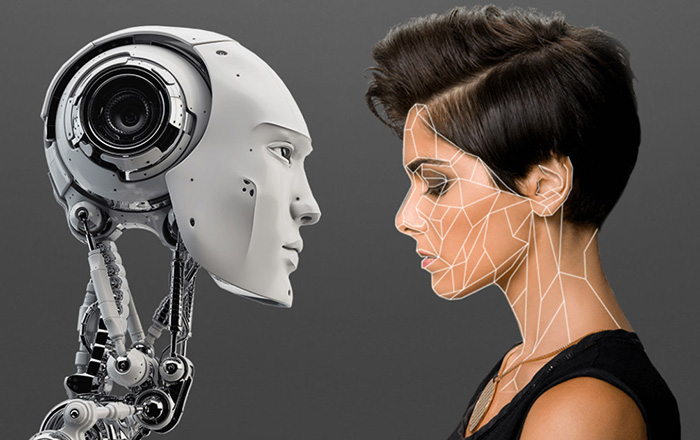

Дослівний переклад терміну трактується як «глибинна підробка». А що ж містить у собі «глибинність»? Можна дібрати кілька прикметників, які пояснюють суть: це не звичайна, а, так би мовити, «надфальсифікація» – ґрунтовна, ретельна та детальна, найважливішою особливістю якої є синтезування та накладання світлин та відео конкретної особи на основі штучного інтелекту.

Джерело: imena.ua

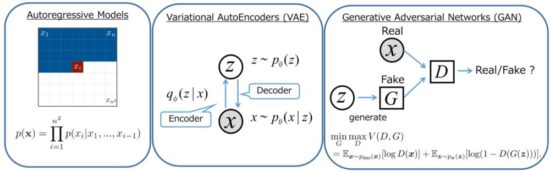

Упродовж цього процесу насамперед використовують генеративно-змагальну нейронну мережу GAN (Generative adversarial network), що є одним із алгоритмів класичного машинного навчання. Завданням якої є творення (генерування) текстів, картинок, музики, відео.

Deep fakе базується на двох нейромережах, де працюють відповідно два алгоритми – «генератор» та «дискрімінатор». Перший – створює задані образи. Завдання другого – розпізнавати створений образ та відрізняти справжні зразки від підроблених, покращуючи роботи першого.

Джерело: wiki.math.uwaterloo.ca

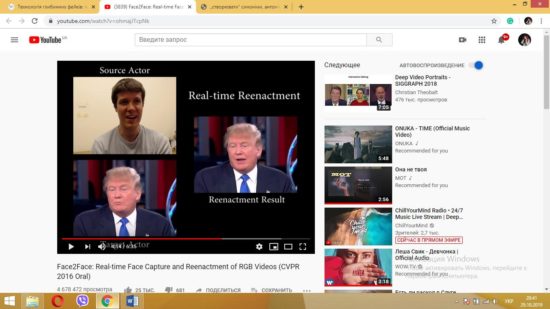

Та все ж задля такої тривкої підробки спершу необхідно віднайти чималу кількість зображень, відео людини (залежно від нашої кінцевої мети) у різних ракурсах та позах, з різними емоціями та жестикуляцією. На основі візуальних вхідних матеріалів нейромережа формує лицеву маску, на якій згодом можна додавати взагалі інші обличчя. Суміжно підкріплюють і відповідний текст, який мовець відтворює.

Відео за посиланням: https://youtu.be/ohmajJTcpNk

Далі справа за алгоритмом GAN – він аналізує та розпочинає генерувати підроблені аудіовізуальні продукти.

Стосовно ж новації фахівець з інформатики Лос-Аламоської національної лабораторії Джастон Мур стверджує: «Алгоритми можуть створювати зображення осіб, котрі належать реальним людям, вони можуть дивним чином переробляти зображення, перетворюючи коня на зебру».

Зрозуміло, що «піддослідними» у цьому ноу-хау виявились обличчя передусім всесвітньо відомих осіб, таких як Дженіфер Лоуренс, Скарлет Йохансон, Ніколас Кейдж, Барак Обама, Дональд Трамп, Марк Цукернберг та ще багато інших.

Такі «deep fakові продукти» можуть бути створені з розважальних мотивів, однак здебільшого їх використовують із конкретними дезінформативними та пропагандистськими маніпуляціями для широкого загалу, як пише у своєму матеріалі Надія Баловсяк на Stopfake. Ба більше, журналістка переконана, що на сучасному етапі найбільшою проблемою постає вседоступність до такого продукування, адже будь-хто за допомогою власного комп’ютера може відтворити все, що заманеться.

Відео за посиланням: https://youtu.be/AmUC4m6w1wo

Відео за посиланням: https://youtu.be/kZecxo95Taw

З цього ж приводу сенатор США Марко Рубіо коментує, що «глибокі підробки» є загрозою національній безпеці: «За старих часів, якщо ви хотіли погрожувати США, вам потрібно було 10 авіаносців, ядерна зброя та ракети дальної дії. Сьогодні ж все, що вам потрібно – це можливість створити дуже реалістичне підроблене відео, яке може підірвати наші вибори, що спричинить велику кризу та нас послабить».

На противагу цьому виокремлюють деякі переваги застосування явища глибинного фейку для розважальної сфери, кіноіндустрії, оскільки можуть відтворювати необхідні кадри з бажаними акторами, місцями, погодою тощо, а також у сфері бізнесу – для автоматичного перекладу тексту.

Все ж, які б плюси не вимальовували аналогічні новації, фейк незмінно залишається фейком. Таким чином наша інформаційна пожива може погано позначитися на нашому стані.

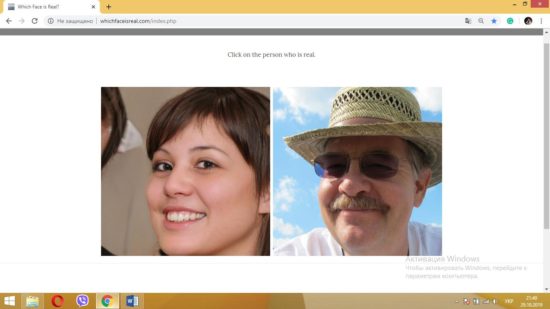

Гра за посиланням: whichfaceisreal.com

Цьогоріч двома професорами Вашингтонського університету було створено ресурс «which face is real?», на якому в ігровій формі користувачу слід обирати між парою облич, одне з котрих є справжнє, а інше – штучно змодельоване системою GAN. Творці запевняють, що їхнім завданням є саме допомогти сучасній генерації інтернет-користувачів: «.. знати про простоту, з якою можна підробити цифрові посвідчення, і допомогти вам помітити ці підробки одним поглядом». На сайті вони наводять конкретні означальні характеристики та приклади типових помилок розробників.

Саме розробка аналогічних інструментів і допоможе пройти осторонь підступної фальсифікації.

Безперечно, ми рухаємось зі швидкістю світла у технологічному напрямку. Щодня впроваджуємо життєво корисні новації. Та все ж, як говориться – існує два протилежні боки медалі. Так і тут – користь чогось одного приносить шкоду іншому. Відповідно унікальність використання deep fake в розважальному контенті породжує загрозу в новинному. Тільки ж обачність, критичність у сприйнятті та певні фахові знання сприятимуть нашому особистісному інформаційному захисту.

Христина Фроляк, студентка факультету журналістики ЛНУ ім. І. Франка