Медіа під впливом нейромереж: коли картинки ШІ підмінюють журналістику

Поліна Хміль

Опубліковано: 05-01-2026

Розділи: За що критикують медіа?, Нові технології медіа, Фальсифікація, містифікація.

0

Останні роки медіапростір переживає стрімку трансформацію під впливом генеративних нейромереж, здатних створювати зображення за лічені секунди. Популярність таких ШІ-картинок стрімко зростає, вони дедалі частіше з’являються у новинах, блогах та починають «брати у полон» соцмережі.

Актуальність цієї теми не викликає сумнівів. З одного боку, технології штучного інтелекту пропонують журналістам та редакціям інструмент для швидкого та економічно вигідного виробництва контенту, розширюючи візуальні можливості. З іншого боку, саме ці характеристики створюють серйозні виклики для професійної журналістики. Особливо вони поєднуються з ризиками поширення дезінформації та зміни того, як читач сприймає медіаматеріал. У цьому аналізі ми спробуємо критично оцінити, як саме ШІ-зображення впливають на журналістські стандарти, довіру аудиторії та загальну якість медіаспоживання.

Що таке генеративні нейромережі?

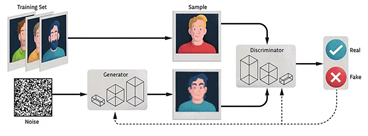

Нейромережі, що спеціалізуються на створенні нового контенту, називають «генеративним ШІ» або просто «генеративними моделями». Це технології, які здатні «вигадувати» й формувати текст, зображення, відео чи аудіо з нуля. Хоч може здатися, що це свіже нововведення, насправді перші спроби таких систем з’явилися ще у 1960-х. Утім, справжній прорив стався лише у 2014 році завдяки досліднику в галузі машинного навчання Яну Ґудфелоу, коли з’явилися генеративні змагальні мережі – GAN–и.

Їхня суть проста: дві нейромережі працюють «у парі». Одна – дискримінатор – навчається на величезній кількості зображень і вчиться розпізнавати, де й що на них зображено. Інша – генератор – бере випадковий шум і крок за кроком перетворює його на картинку, намагаючись обдурити дискримінатор так, щоб той прийняв її за справжнє фото. Через такі «змагання» моделі стають дедалі кращими й сьогодні здатні за кілька секунд видавати надзвичайно реалістичні зображення – саме тому генеративний AI отримав таку популярність.

Сьогодні існує безліч таких генеративних моделей. Найвідоміші серед них DALL·E, Midjourney, Stable Diffusion для картинок, ChatGPT та GPT-4 для тексту, а також музичні та відео-генератори на базі ШІ. Вони дозволяють за кілька секунд отримувати високоякісний контент із мінімальними зусиллями користувача.

Підміна реального візуального документування

Штучний інтелект увірвався в ньюзруми настільки стрімко, що традиційні «правила гри» та етичні кодекси миттєво застаріли. Те, що вчора здавалося безневинною цифровою забавкою, сьогодні загрожує самим основам професії. Ми стали свідками небезпечного зсуву: алгоритми не просто допомагають створювати контент, вони починають витісняти суть журналістики, пропонуючи аудиторії синтетичний замінник замість задокументованої правди.

Сьогодні редакції та контент-мейкери дедалі частіше піддаються спокусі проілюструвати подію яскравою, драматичною «картинкою», створеною Midjourney, DALL-E чи Google AI, замість того, щоб купувати ліцензійне репортажне фото або відправляти кореспондента в епіцентр подій. Це особливо помітно в темах, де візуалізація є складною, дорогою або небезпечною: масштабні екологічні катастрофи, бойові дії, абстрактні економічні процеси.

Ризик такої практики полягає у створенні викривленого, «кінематографічного» уявлення про подію. Коли новину про реальну лісову пожежу ілюструють згенерованим зображенням «ідеального вогню», читач отримує гіперболізовану естетику замість правди. Це формує завищені очікування від візуального контенту: реальні фотографії війни чи катастроф можуть здаватися аудиторії «недостатньо драматичними» або «блідими» порівняно з насиченими галюцинаціями нейромереж. Відбувається підміна фактів естетикою, де головним критерієм стає не правдивість, а сила емоційного враження.

Яскравим прикладом такої підміни стала ситуація навколо руйнівних лісових пожеж у Каліфорнії в січні 2025 року. Пожежі в Палісейдс та Ітоні (округ Лос-Анджелес) стали історично руйнівними, знищивши понад 10 000 будинків та завдавши збитків на сотні мільярдів доларів.

На тлі цієї реальної трагедії у лютому 2025 року соціальні мережі, зокрема південнокорейський сегмент Facebook, сколихнуло зворушливе зображення: група пожежників стоїть на колінах у молитві перед стіною велетенського полум’я. Підпис корейською мовою стверджував: «На фото видно пожежників, які стоять на колінах у молитві після того, як вони зробили все можливе, щоб загасити вогонь, але не змогли».

Однак розслідування AFP Fact Check довело, що це – стовідсоткова синтетика. Журналісти агенції разом з експертами з медіа-криміналістики вказали на типові для нейромереж «галюцинації»: нечитабельні написи на

формі, спотворені деталі машин та алогічну дорожню розмітку. Ба більше, зображення навіть містило прихований водяний знак SynthID, що вказував на генерацію інструментами Google.

Інцидент підсвічує критичну проблему: навіть наявність маркування не рятує від дезінформації, якщо фейк влучає в емоційний нерв суспільства. ШІ згенерував «досконалу трагедію», яка виявилася для користувачів переконливішою за реальність. Аудиторія масово прийняла цю симуляцію, ігноруючи докази підробки заради отримання сильного емоційного переживання.

Фабрика ілюзій: як ШІ спотворює реальність

Генератори зображень стали ідеальним каталізатором дезінформації. Вони дозволяють візуалізувати вигадку з фотографічною точністю, перетворюючи фантазії на вірусні новини, які мільйони людей сприймають за чисту монету.

Першим «дзвіночком» став кейс «Папа Римський у пуховику Balenciaga» (березень 2023). Згенероване Midjourney фото ошукало навіть експертів моди та провідні медіа. Цей відносно невинний випадок довів фундаментальну річ: людське око та професійна інтуїція більше не здатні надійно відрізняти якісну синтетику від реальності.

Підроблені фотографії, створені програмним забезпеченням штучного інтелекту, ймовірно, показують Папу Франциска, який виходить за межі Ватикану в дизайнерському пальто, чого він ніколи не робив / CBS News

Значно небезпечнішим прецедентом стала серія зображень «арешту Дональда Трампа», створена Еліотом Гіґґінсом. Попри чітке маркування автором, картинки зажили власним життям у соцмережах. Вони сформували альтернативну реальність для електорату ще до того, як будь-які офіційні події відбулися, продемонструвавши потенціал ШІ у політичних маніпуляціях.

В умовах війни ШІ перетворився на повноцінну інформаційну зброю. Російська пропаганда використовує генерацію для фабрикації поразок ЗСУ та сіяння паніки. Яскравий приклад, наведений нещодавно Центром протидії дезінформації – фейкове відео «виходу поранених військових з Покровська». Попри спробу ворога надати ролику правдоподібності через різні ракурси, програмний аналіз виявив грубі помилки нейромережі: ноші, що левітують, автономні крісла колісні та «зайві» кінцівки у людей.

Головна загроза таких кейсів – асиметрія швидкості. ШІ дозволяє сфабрикувати емоційні «відеодокази» за лічені секунди. І поки фактчекери аналізують технічні аномалії, дезінформація вже встигає деморалізувати аудиторію в соцмережах.

Штучна естетизація війни як безпековий та етичний виклик

Масове використання ШІ в українських медіа не лише порушує професійні стандарти, а й переростає у серйозний безпековий виклик. Як наголосила директорка ІМІ Оксана Романюк на конференції «ДезАут» (жовтень 2024), діпфейки та маніпуляції стали ключовою загрозою, проти якої в нас досі фактично немає дієвих механізмів захисту.

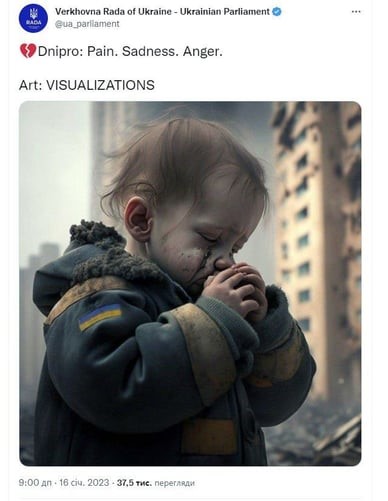

Ця технологічна беззахисність поглиблюється етичною прірвою – штучною естетизацією трагедії. Показовим став кейс із «дитиною з Дніпра» (січень 2023), коли на тлі реальної рятувальної операції офіційні джерела поширили згенероване фото дитини, що плпакал . Тисячі людей у коментарях молилися за цифровий симулякр, ігноруючи страшну, але не таку «естетичну» реальність поруч.

Історик Володимир В’ятрович влучно пояснив цей феномен: суспільство підсвідомо прагне, аби війна виглядала «яскраво і щемко», оскільки справжня трагедія часто надто огидна або блокується алгоритмами соцмереж. Проте толерантність до таких «красивих фейків», за словами медіакритика Отара Довженка, грає на руку ворогу.

«Аргументи людей, які запостили згенеровану штучним інтелектом не дуже правдоподібну картинку «хлопчика з Дніпра», вважаючи її фотографією, а потім, дізнавшись, що це витвір комп’ютера, доводять, що нема різниці — це одна з найстрьомніших речей, які я бачив останнім часом.

Людям пофіг, правда чи ні, їм подобається ілюзія, яку вони собі обрали. Малюнок чи фотографія — нема різниці».

Регуляція та нові правила гри

Світ уже пройшов точку неповернення у сприйнятті штучного інтелекту: ігнорувати технологію більше неможливо, тому акцент змістився на її регулювання. Першим глобальним бар’єром для хаосу став EU AI Act, що на законодавчому рівні закріпив вимогу обов’язкового маркування синтетичного контенту. Користувач має право знати, хто є автором повідомлення – людина чи алгоритм. Техногіганти не залишились осторонь: Google (через інструмент SynthID) та Meta почали інтегрувати у згенеровані файли приховані водяні знаки та метадані, що дозволяє ідентифікувати «нерукотворний» контент автоматично.

Однак у ньюзрумах ситуація залишається неоднозначною, адже редакції балансують між етичними стандартами та необхідністю економити ресурси. Медіаексперт Олексій Мінаков підкреслює прагматичний бік питання: використання ШІ є цілком виправданим для креативних та абстрактних завдань. Коли бюджет не дозволяє провести зйомку або тема є загальною (як-от «психологія» чи «майбутнє»), нейромережа здатна створити якіснішу та більш персоналізовану ілюстрацію, ніж банальні фото зі стоків.

Водночас Мінаков застерігає: фотореалістичні зображення можуть вводити аудиторію в оману. Значно менше ризиків несуть карикатурні чи стилізовані ілюстрації, а також графіки та схеми – там глядач одразу розуміє, що це художній образ, а не документальне фото.

Тоді ж виникає головне правило медіагігієни – прозорість. Використання ШІ припустиме для художніх та пояснювальних матеріалів, проте категорично неприпустиме для новин про війну, катастрофи чи судові процеси. Медіа повинні маркувати будь-який генеративний контент, а аудиторії варто розвивати навички візуального фактчекінгу: звертати увагу на неприродні деталі, перевіряти сумнівні кадри через TinEye чи Google Images та шукати маркування «створено ШІ». Лише так можна уникнути пастки дезінформації в епоху синтетичних медіа.

Поліна Хміль, студентка факультету журналістики ЛНУ ім. Івана Франка

Джерела:

- What’s the latest on Los Angeles wildfires and how did they start? BBC https://www.bbc.com/news/articles/clyxypryrnko

- Пожежа в Лос-Анджелесі https://factcheck.afp.com/doc.afp.com.36XQ8KQ?utm_source

- Fake photos of Pope Francis in a puffer jacket go viral, highlighting the power and peril of AI https://www.cbsnews.com/news/pope-francis-puffer-jacket-fake-photos-deepfake-power-peril-of-ai/

- «Арешт Дональда Трампа», Еліот Гіґґінс https://x.com/EliotHiggins/status/1637927681734987777?s=20

- ШІ-фейк про вихід з Покровська. ЦПД https://www.facebook.com/protydiyadezinformatsiyi.cpd/photos/D1%82%D1%8C-%D1%84%D0%B5%D0%B9%D0%BA/851151847433882/

- Дезінформація, регулювання соцмереж та ШІ-фейки: Романюк окреслила ключові виклики для інформаційної сфери https://imi.org.ua/news/dezinformatsiya-regulyuvannya-sotsmerezh-ta-shi-fejky-romanyuk-okreslyla-klyuchovi-vyklyky-dlya-i64546?

- Фото «хлопчика з Дніпра». У соцмереаж парламенту його вже немає, тому лишаю активний варіант https://x.com/KorsunskySergiy/status/1615138211243896832

- Допис Отара Довженка https://www.facebook.com/otardovzhenko/posts/pfbid024dXx5FLiyegm97nfNQMa8jo9mcJyCXF12xwJxkBKQNhuZ5dA9icMTxsvMdaLiqzEl

- Використання ШІ в медіа: як зберегти якість контенту. Інтерв’ю з експертом із ШІ Олексієм Мінаковим https://imi.org.ua/monitorings/vykorystannya-shi-v-media-yak-zberegty-yakist-kontentu-interv-yu-z-ekspertom-iz-shi-oleksiyem-i67331

- Як працюють генеративні нейромережі https://medium.com/%40aliharis1801/generative-adversarial-networks-gans-demystified-how-ai-learns-to-create-017d8e9cad92